A quienes les guste el juego y las apuestas, tienen tres buenas opciones hoy en día: los casinos, Bitcoin y las acciones de Tesla. Se han escrito ríos de tinta sobre Tesla, con acérrimos detractores y fanáticos defensores. Pero hay sorprendentemente pocos artículos que profundicen en el caso, que es lo que yo voy a intentar hacer a continuación.

A quienes les guste el juego y las apuestas, tienen tres buenas opciones hoy en día: los casinos, Bitcoin y las acciones de Tesla. Se han escrito ríos de tinta sobre Tesla, con acérrimos detractores y fanáticos defensores. Pero hay sorprendentemente pocos artículos que profundicen en el caso, que es lo que yo voy a intentar hacer a continuación.

En agosto de 2018, Elon Musk, probablemente hastiado de bullies financieros, tweeteó que tenía asegurada financiación para privatizar Tesla sacándola del mercado bursátil a 420$ por acción. En aquel entonces, las acciones rondaban los 380$, y el tweet le costó a Musk una multa de la SEC por 20 milones de dólares a pagar de su propio bolsillo más su dimisión forzosa cómo Chairman of the Board en Tesla y una caída del 14% de la noche a la mañana en el valor de las acciones. Menos de un año y medio después, mientras escribo este artículo, las acciones de Tesla cotizan por encima de 430$.

La volatilidad de las acciones de Tesla es tal que ahora mismo es más probable ganar dinero jugando a la ruleta que comprando acciones de Tesla. Bastó un informe del analista Daniel Ives de Wedbush diciendo que se esperaba un incremento de la demanda del Modelo 3 para que el precio de la acción subiese de golpe 100$ de 270$ a 370$. Eso a pesar de que ya existe una lista de espera de más de un año para el Modelo 3.

Pero es que precio de las acciones de Tesla subió incluso cuando en 2015 la empresa publicó un April’s Fool note (el equivalente anglosajón al Día de los Santos Inocentes) anunciando que sacarían al mercado un reloj de pulsera réplica del Big Ben, porque hay bots que escanean constantemente la red en busca de noticias sobre Tesla para comprar o vender en cuestión de milisegundos.

Pero es que precio de las acciones de Tesla subió incluso cuando en 2015 la empresa publicó un April’s Fool note (el equivalente anglosajón al Día de los Santos Inocentes) anunciando que sacarían al mercado un reloj de pulsera réplica del Big Ben, porque hay bots que escanean constantemente la red en busca de noticias sobre Tesla para comprar o vender en cuestión de milisegundos.

Entonces ¿Está justificado o no el precio de las acciones de Tesla? Y ¿Cual es la esperanza de viabilidad de Tesla? Trataré de responder de forma razonada a estas cuestiones. Pero, antes de hacerlo, tengo que decir que el precio de las acciones de cualquier empresa lo fija la oferta y la demanda con independencia de valoraciones objetivas, y nadie tiene una bola de cristal para predecir el futuro.

Mercado

Una empresa existe sólo para servir a un mercado. Ese mercado consiste en que a medio plazo tenemos que cambiar casi todos los coches con motor de combustión interna a eléctricos. Las razones son dos: 1ª) el transporte genera un 22% de las emisiones de CO₂ del cual los coches suponen una fracción significativa, y 2ª) tarde o temprano nos quedaremos sin suficiente petróleo para repostar los coches.

Existen pruebas de que la transición hacia el coche eléctrico es posible. En Noruega, por ejemplo, el gobierno se tomó en serio la lucha contra el cambio climático y la polución. El gobierno y las administraciones noruegas empezaron a dar todo tipo de incentivos a los coches eléctricos. Actualmente el 77% de los nuevos coches que se venden en Oslo son eléctricos, lo cual ha reducido un 9% las emisiones de CO₂ en la ciudad. Además, en Noruega existe un plan para eliminar todos los coches de combustión en 6 años.

Los motores de combustión interna son muy poco eficientes energéticamente. En ellos sólo aproximadamente el 30% de la energía se convierte en trabajo para mover el coche, el resto se disipa mayormente en forma de calor y ruido. De acuerdo con las estimaciones, se necesitan aproximadamente 6 kW⋅h para refinar un galón (3,78l) de gasolina. Eso sin tener en cuenta la energía requerida para extraer el crudo y transportarlo (entre 250 y 400 kW⋅h por barril). Con 4 litros un coche del peso y tamaño de un Tesla anda unos 40 Km. Pero con los mismos 6 kW⋅h un Tesla puede recorrer unos unos 32Km convirtiendo hasta un 70% de la energía almacenada en la batería en trabajo para mover el coche. Incluso quemando carbón en una central térmica para producir electricidad se generaría un 20% menos de dióxido de carbono del que producen los coches con motores de combustión.

Además de mucho más silenciosos y eficientes energéticamente, los coches eléctricos son más simples en otros aspectos. Un coche moderno con motor de combustión interna puede tener hasta 2.000 partes móviles mientras que en un coche eléctrico la cifra puede reducirse a alrededor de 200.

El mercado para coches eléctricos existe, es enorme y está creciendo. Además, los grandes fabricantes de coche se enfrentan a autolimitaciones (lock-in) que explicaré más adelante y que proporcionan una buena oportunidad para un nuevo proveedor disruptivo cómo Tesla. En resumen, Tesla tiene una oportunidad y su estrategia tiene bastante sentido.

Por otra parte, el atractivo de un mercado depende no sólo de su tamaño y ritmo de crecimiento sino también de cuántos competidores con pulmón financiero están entrando. En el caso de los coches eléctricos el número de competidores es toda la industria automovilística del Mundo Mundial. Tesla en realidad sólo ofrece tres del total de cincuenta y un modelos de coches eléctricos comercialmente disponibles. El CEO de Volkswagen, Herbert Diess, dijo recientemente que habrá que sacrificar algunas “vacas sagradas” y que y “el tiempo de los fabricantes de automóviles clásicos ha terminado”.

Tanto Mercedes como BMW han anunciado que crearán spin-offs específicas para su marca de coches eléctricos. En dos años o incluso menos se esperan en el mercado cuatro modelos eléctricos de Mercedes, otros cuatro de BMW, siete de Volkswagen (quién además tiene una alianza estratégica con Ford para el desarrollo de conducción autónoma). Volkswagen es un grupo gigante que integra (entre otras) las marcas: Audi, Bentley, Porsche y Lamborghini, con más de diez millones de coches vendidos en 2019. Audi ha anunciado tres modelos, uno Bentley, uno Jaguar, uno Maserati y uno Aston Martin. Porsche ha recibido 30.000 prerreservas y 10.000 pedidos para su nuevo modelo Tycan a 103.800$ la unidad. Y todavía ni hemos mencionado a los chinos, surcoreanos y japoneses.

Distribución

Lo primero que hay que entender sobre Tesla es que su ventaja competitiva no es sólo ofrecer coches con motores eléctricos. El motor eléctrico tiene una larga historia que se remonta al siglo XIX y que esbozaré en un apéndice. Además de coches, Tesla vende soluciones de energía limpia que le permitirían pivotar durante una crisis, pero sólo comentaré aquí la línea de negocio de coches.

Tesla es un empresa con integración vertical. Los fabricantes de coches no producen ellos mismos las piezas que necesitan ni venden directamente sino a través de concesionarios, ni reparan sino a través de talleres con los que hacen un pingüe negocio proveyendo sobrevalorados recambios originales. Tesla aspira a convertirse en el iPhone de los coches, fabricando ella misma muchas de las piezas que necesita y vendiendo y reparando directamente, sin intermediarios. Esto no implica que Tesla carezca de tiendas dónde el cliente pueda acercarse a ver y probar el producto. Aunque a mediados de 2019 Tesla cerró la mayoría de sus 378 tiendas, en parte por el coste de mantenerlas y en parte porque, según Elon Musk, el 78% de los propietarios de un Modelo 3 lo compra online y el 82% compra sin haber hecho ninguna prueba previa de conducción. Tesla, no obstante, no es la única vendiendo online. Hasta dónde yo sé, al menos BMW también ha hecho pruebas de vender Mini directamente sin intermediarios en algunos mercados.

Hacerlo todo uno mismo tiene sus ventajas y sus inconvenientes. Los fabricantes de coches subcontratan y externalizan porque eso les permite flexibilizar su estructura de costes y escalar más fácilmente. Durante la crisis de 2008 en Europa y EE.UU. se redujo, más o menos, un 20% la venta de coches. Los fabricantes pueden repercutir parte de esa caída en sus proveedores y sus redes comerciales y de mantenimiento, subvencionándolas, si acaso, para que no desaparezcan. Por ejemplo, el fabricante puede ampliar la garantía gratuita de modo que los clientes acudan con mayor frecuencia y regularidad al taller en época de crisis.

Yo no tengo nada claro que el modelo de integración vertical de Tesla sea mejor. Quizá es que simplemente no tengan otra posibilidad de abastecerse. Por la parte de la venta directa, sí es una ventaja competitiva pues existen múltiples ejemplos de éxito en desintermediación vía Internet.

Sobre el mantenimiento no estoy seguro por dos razones: 1ª) no es lo mismo reparar un iPhone que reparar un Tesla y 2ª) la supervivencia de un negocio también depende de las externalidades que genera. En un iPhone roto se puede reparar el cristal y poco más. Y en el caso de pérdida total irreparable para Apple es fácil, rápido y relativamente barato proporcionar un iPhone nuevo. Pero ¿qué sucede si se siniestra un Tesla? ¿el propietario tiene que esperar otro año por uno nuevo? Y en cuanto a los talleres ¿quién no tiene un mecánico de confianza? Un ejemplo comparativo: parte del éxito de Salesforce se atribuye a que genera más negocio para los partners que para sí misma. Esto históricamente ha sido así para la mayoría de los proveedores de software B2B: IBM, Oracle, Microsoft… Pero ¿qué pasa cuando una empresa intenta fagocitar el negocio de tus antiguos aliados? Creo que la historia de Apple proporciona la respuesta: se produce una división entre los consumidores, una minoría se va al vendedor más privativo y el resto se va al mercado commodity de coches con baterías LG y software de Cognizant y Alphabet Waymo corriendo sobre hardware NVIDIA.

Sin embargo, existe una buena razón por la que a Tesla el mantenimiento le resulta mucho más sencillo que a un fabricante de coches con motor de combustión. Cómo ya hemos comentado, un coche eléctrico tiene menos piezas móviles que uno de gasolina. Menos piezas implica menos posibilidades de fallo y menos reparaciones. Un fenómeno que ha venido sucediendo en la industria automovilística en las últimas décadas es que que, a medida que se difundía el conocimiento, la tecnología y la disponibilidad de piezas, a los fabricantes se les hacía paulatinamente más difícil diferenciarse de sus competidores. Para lograrlo, los fabricantes norteamericanos y alemanes fueron complicando cada vez más el diseño. Pero a mayor complejidad más fallos. Lo que los fabricantes hacen es intentar lanzar una versión exitosa de un modelo y luego modificarla para reducir los costes de producción tanto cómo puedan. El resultado son coches caros y complejos que necesitan frecuentes visitas al taller para costosas reparaciones. Los clientes se percataron del fenómeno y en parte por eso empezaron a elegir coches japoneses que además de ser más baratos se averiaban menos. Parte del plan estratégico de Tesla es casi con seguridad llevar la resiliencia de los vehículos un paso más lejos para que, en general, no necesiten reparaciones al menos en 200.000 Km.

Hay que decir para ser justos que Tesla no es la única intentando controlar el negocio de post-venta. BMW, Mercedes, Audi y, en general, todos los fabricantes de vehículos de gama alta llevan décadas haciendo todo lo posible para que sean imposibles de reparar fuera de la red de talleres oficiales.

Producto

Además del motor eléctrico, Tesla vende, o más bien vendía, conducción autónoma. El problema principal de la conducción autónoma es que es dificilísima de lograr en todas las condiciones climatológicas y ambientes urbanos. No es lo mismo conducir por una autopista recta y bien señalizada que por una sinuosa carretera de montaña en los Alpes con niebla y el suelo helado. No es lo mismo ir por el carril preferente para coches eléctricos en una ciudad europea que ir por las calles sin semáforos ni normas de tráfico de El Cairo.

El problema de la conducción 100% autónoma es tan arduo de resolver que cada día se habla menos de él para no generar falsas expectativas ¿alguien se acuerda de los coches que se conducían ellos solos de Google? Habrá sin ninguna duda coches 100% autónomos en un futuro no lejano. Seguramente los primeros aparecerán para transporte de mercancías o cómo alternativa a los taxis y autobuses públicos ofreciendo rutas personalizadas puerta-a-puerta. Lo que dudo es que Tesla pueda apalancarse en la conducción autónoma como ventaja competitiva. Tesla ni siquiera está en el top 10 de poseedores de patentes de conducción autónoma, acaparado por los alemanes con Bosch a la cabeza. No obstante, Tesla tiene dos activos de gran valor en lo referente a conducción autónoma: 1º) los datos recogidos por sus vehículos durante los millones de horas de uso. Siendo la conducción autónoma un problema de machine learning, el que está en mejor posición para resolverlo es el que tiene más datos para entrenar a la inteligencia artificial y 2º) su nuevo hardware HW3 que proclama ser hasta 20 veces más potente que el hardware basado en Nvidia que usan el resto de fabricantes.

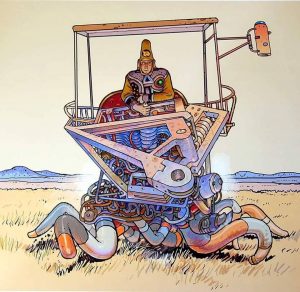

Una diferencia importante de los coches que se conducen por si mismos es que el interior no tiene por qué parecerse en absoluto al de un coche clásico. Para empezar, en un coche 100% autónomo ni siquiera sería necesario que hubiese un conductor mirando constantemente hacia la carretera. En cambio, los pasajeros podrían ir sentados alrededor de una mesa central.

Una diferencia importante de los coches que se conducen por si mismos es que el interior no tiene por qué parecerse en absoluto al de un coche clásico. Para empezar, en un coche 100% autónomo ni siquiera sería necesario que hubiese un conductor mirando constantemente hacia la carretera. En cambio, los pasajeros podrían ir sentados alrededor de una mesa central.

Tesla ha dado pasos importantes en la modificación del interfaz de usuario, posiblemente llevándolo demasiado lejos demasiado pronto. El Modelo 3 tiene una pantalla de 15″ y el Modelo X una de 17″. Tesla ha intentado centralizarlo todo en un dashboard de control. Esto tiene dos grandes inconvenientes: 1) es imposible hacer nada en el dashboard sin quitar la vista de la carretera lo cual puede suponer un grave peligro, y 2) la pantalla es un punto único de fallo, si se rompe o deja de funcionar adecuadamente por un problema software, eso es casi lo mismo que todo el coche quede inoperante.

Tesla ha dado pasos importantes en la modificación del interfaz de usuario, posiblemente llevándolo demasiado lejos demasiado pronto. El Modelo 3 tiene una pantalla de 15″ y el Modelo X una de 17″. Tesla ha intentado centralizarlo todo en un dashboard de control. Esto tiene dos grandes inconvenientes: 1) es imposible hacer nada en el dashboard sin quitar la vista de la carretera lo cual puede suponer un grave peligro, y 2) la pantalla es un punto único de fallo, si se rompe o deja de funcionar adecuadamente por un problema software, eso es casi lo mismo que todo el coche quede inoperante.

Mención aparte merece el anuncio del nuevo cibercamión. Diseñado por el reputado Franz von Holzhausen. Cuyo objetivo es reemplazar a la Serie F de camionetas de Ford que en EE. U.U. lleva siendo el modelo de coche más vendido durante 42 años consecutivos. Tesla ha recibido 250.000 prerreservas por 100$ (reembolsables) cada una sólo para estar en la lista de espera de un vehículo que se podrá configurar y encargar (que no recibir) a finales de 2021. La fabricación del cibercamión es especialmente difícil porque el chasis ha sido reemplazado por un exoesqueleto de acero extra-duro de 3mm a prueba de balas de 9mm que no es maleable cómo el acero normalmente usado en automoción, y de ahí las formas angulosas. Si el cibercamión cumple lo que promete, podría ser un bombazo. La versión con tres motores puede arrastrar más y cargar más peso que una camioneta clásica además de ser más rápido.

Precio

Seré muy breve sobre el precio. Porque aunque es un elemento crucial del marketing mix en el caso de Tesla su política de precios es fácil de entender. Cómo no pueden fabricar lo bastante rápido, intentan ir a por la gama alta del mercado dónde el margen bruto es comparativamente mayor, entre el 18% y el 20% que en gama media-baja dónde suele oscilar entre el 12% y el 18%. Los márgenes brutos de Tesla se parecen a los de BMW y Mercedes y es esperable que a medida que se introduzcan modelos cada vez más baratos los márgenes de Tesla tenderán a la baja.

El cibercamión tiene una importante barrera de entrada debido a su coste. La versión básica con un motor empezará en 39.000$, el doble que una Ford F-150. La versión con dos motores se ofrecerá por 49.000$ y la de tres motores por 69.000$

Además del precio de compra, es necesario considerar el coste total de propiedad: precio de compra + combustible + seguro + reparaciones. Sobre el combustible se estima que el coste medio anual de recarga en EE.UU. para un coche eléctrico son 485$ mientras que la gasolina para el mismo númnero de kilómetros recorridos cuesta 1.117$. Y esto es en un país dónde la gasolina es especialmente barata.

Posición financiera

El aspecto más controvertido de Tesla es su posición financiera. A final de 2019, Tesla tiene 13.300 milones de deuda. Una capitalización de mercado de 78.000 millones de dólares y unos 440.000 dólares de ingreso bruto anual por empleado. En general, los ratios financieros clásicos cómo el ROI y el EPS no son en absoluto para tirar cohetes.

Para poner esto en contexto, la capitalización de Ford es de 37.000 millones y tiene más de 100.000 millones de deuda. Ford vendió en 2018 algo más de 2 millones de automóviles en EE. UU. con un beneficio de 7.000 milones y Tesla no alcanzó los 200.000 automóviles con 1.690 millones de pérdidas.

O sea, el mercado cree que Tesla vale el doble que Ford o BMW. A pesar de que para alcanzar el volumen de ventas de cualquiera de ambos tendrá no sólo que endeudarse aún más construyendo nuevas factorias sino también defenderse de los alemanes, los chinos, los surcoreanos y los japoneses.

Una ventaja importante de Tesla para los especuladores, especialmente los que hacen trading diario, es que su volumen de acciones vendidas y compradas a diario es bastante alto. Tanto cómo el 25% de todas las transacciones de compra-venta de acciones de Tesla son a corto (shorted) lo cual quiere decir que el comprador de la acción no es su propietario real sino que ha pedido un préstamo para comprarlas y luego revenderlas en muy breve espacio de tiempo, a menudo, el mismo día de la compra.

Tendencias

Para predecir el futuro próximo de Tesla vamos a fijarnos en su evolución de ventas y cuota de mercado entre 2014 y 2018. Tesla vendió en 2014 16.689 coches en EE.UU. con una cuota de mercado del 0,11%. En los cuatro años siguientes obtuvo una cuota de mercado estadounidense del 1,11% en 2018, pero las ventas entre 2017 y 2018 casi se cuadruplicaron pasando de 50.145 vehículos en 2017 a 191.627 en 2018.

Tesla vendió en 2018 más coches de su Modelo 3, 138.000 unidades, que Lexus RX, 111.000 unidades o BMW Series 3 y 4, 76.000 unidades, además de tener 100.000 coches en lista de espera en Europa. En 2019 se espera que el número total de Teslas vendidos en todo el mundo oscile entre 360.000 y 400.000 unidades.

Comparando Tesla en EE. UU. con Lexus, BMW, Mercedes, Volvo, Audi, Cadillac y Land Rover, Tesla les está ganando. De las marcas anteriores sólo BMW, Volvo y Land Rover ganaron cuota de mercado en 2018. Lexus cayó de un 1,77% (305.229 uds) en 2017 a un 1,72% (298.302 uds). Cadillac cayó de un 0,91% (156.440 uds) a un 0,89% (154.702 uds) entre 2017 y 2018. En general, parece que Tesla le está robando cuota de mercado al resto de marcas de gama alta. Las cifras absolutas están lejos de los 2 milllones de coches vendidos por Ford en EE. UU. pero Ford vendió en 2018 un millón menos de coches en EE. UU. de los que vendió en 1998.

En cierto modo, liquidar a la competencia no es tan difícil para Tesla porque ya anda moribunda desde la crisis de 2008 incluso sin que Tesla tenga nada que ver. Tanto General Motors cómo Chrysler declararon suspensión de pagos durante la crisis. Ford sobrevivió pero con considerable erosión.

Posibilidades de producción

Tesla cuenta a finales de 2019 con cinco factorías total o parcialmente operativas:

- Su factoría original en Freemont (California).

- Una gran almacén en Lathrop (California) destinado principalmente a piezas para la factoría de Freemont.

- Gigafactory 1 en Sparks (Nevada).

- Gigafactory 2 en Buffalo (NY). Esta no fabrica piezas ni productos terminados de automoción sino que pertenece a la filial SolarCity.

- Gigafactory 3 en Shanghai (China).

El coste total de la Gigafactory 1 para cuando esté terminada en 2020 se estima en 5.000 millones de dólares. La Gigafactory 1 tendrá capacidad para producir baterías y otras piezas para 500.000 automóviles al año. Con sus 510.000 m² (115 campos de fútbol) la Gigafactory 1 será el edificio más grande del mundo en superficie.

Estas cifras pueden parecer apabullantes, pero no tanto si se tiene en cuenta que Ford cuenta con 72 factorías en todo el mundo. La ventaja de Tesla es que las baterías son difíciles de fabricar en grandes cantidades, un desafío en el que Tesla lleva años trabajando a través de inversiones en infraestructura propia, adquisiciones y una joint venture con Panasonic. Por ejemplo, de los 25.000 coches eléctricos que Mercedes pretendía vender en 2019, sólo consiguió fabricar unos 7,000, mientras tanto, Mercedes sigue mostrando en las exposiciones prototipos que nunca verán la calle junto con modelos de gasolina cómo producto estrella.

Lock-in de los fabricantes actuales

Las fortalezas de todas las grandes empresas son una de las cosas que las ancla al pasado. En el caso de la automoción, los alemanes, japoneses, surcoreanos y norteamericanos cuentan con gran experiencia, capacidad de producción y apoyo gubernativo. Esto les ha hecho adoptar una posición estratégica de second movers frente a Tesla. En parte porque no quieren cambiar y en parte porque no pueden hacerlo fácilmente.

La industria automovilística genera mucho empleo y, en Europa, cada vez que se menciona el término expediente de regulación de empleo se levantan barricadas. Esto es debido a una concepción errónea del empleo y el bienestar social tanto por parte de los políticos cómo por parte de los propios trabajadores. Lo que el Estado debe hacer es velar por el bienestar de los ciudadanos pero no necesariamente tratando de preservar los empleos existentes a toda costa. Lo que hay que procurar es que mientras se destruyen empleos por una parte se están creando por otra y con mayor valor añadido de manera que si no es posible recolocar a todos los trabajadores al menos sí es posible subsidiarlos o prejubilarlos con los nuevos ingresos.

En este sentido, los chinos cuentan con una ventaja competitiva. En Europa se tardan 10 años en tomar una decisión y, cuando se toma, lo que se pone en práctica es el 10% de la idea original. Valgan para muestra de ello los aberrantes y caros coches híbridos que la industria tradicional introdujo para atender a la creciente demanda de coches menos contaminantes. En China es difícil acceder al gobierno y convencerle de que cambie algo pero una vez que se ha tomado la decisión de que una determinada región los coches deben ser eléctricos, se crea un plan para instalar 50.000 puntos de recarga que están operativos en dos meses.

Impacto en la industria del seguro.

¿Qué sentido tiene ser el tomador de un seguro de un coche que no conduces? El siguiente paso natural para Tesla es ofrecer un seguro junto con el coche.

Impacto sobre la red eléctrica

Existe un límite máximo a la velocidad de transición hacia el coche eléctrico fijado por la capacidad de las redes eléctricas existentes.

Según la red eléctrica británica, cambiar todos los coche a eléctricos en Gran Bretaña podría requerir 18GW adicionales de capacidad por encima del pico actual de 60GW. Para tener una idea de lo que es esta cantidad, la central nuclear Hinkley Point C, en construcción en Somerset, añadirá 3,2GW y está prevista su finalización para 2025 con un coste total de 22.000 millones de libras esterlinas. Pero el problema no sólo es de generación sino también de transporte y distribución. En los últimos 20 o 30 años el consumo eléctrico no ha variado mucho. El coche eléctrico es el mayor crecimiento singular en la demanda de electricidad desde la popularización del aire acondicionado.

Mi valoración personal

Pase lo que pase en los próximos años, Tesla ya ha hecho historia precipitando el mayor cambio en el transporte desde la transición de la máquina de vapor al motor de combustión interna. En diez o veinte años no sólo tendremos coches 100% eléctricos que se conduzcan ellos mismos sino que será ilegal conducir manualmente un coche de combustión interna debido al riesgo vial y a los efectos contaminantes.

Subjetivamente, opino que las acciones de Tesla están fuertemente sobrevaloradas y probablemente subirán aún mucho más por encima de los 1.000$. Pero teniendo en cuenta la demanda, las posibilidades de producción, la deuda, la necesidad de mayores inversiones y el aumento de la competencia, opino que el precio de la acción de Tesla no debería superar los 250$. Aunque el precio cayese a la mitad desde los 430$ actuales, la capitalización de mercado de Tesla todavía rondaría los 37.000 millones de dólares. Una capitalización similar a la de Audi, que vendió 1.800.000 coches en todo el mundo en 2018 frente a los 360.000 a 400.000 que se estima que Tesla habrá vendido en 2019.

Tesla ha incumpido en múltiples ocasiones sus plazos de entrega y objetivos de producción. Tiene una alta rotación de directivos. 41 bajas de ejecutivos en 2018 incluyendo el jefe de contabilidad. El CFO en enero de 2019, el CTO en julio. Y en diciembre el abogado principal.

El anuncio de Elon Musk de poner un millón de taxis autónomos en circulación hacia finales de 2020 para que sus propietarios ganen dinero cómo los conductores de Uber pero sin conducir, me parece infactible por cuatro motivos:

El anuncio de Elon Musk de poner un millón de taxis autónomos en circulación hacia finales de 2020 para que sus propietarios ganen dinero cómo los conductores de Uber pero sin conducir, me parece infactible por cuatro motivos:

-

- La tecnología de conducción 100% autónoma aún no está lista. Los Tesla pueden realizar por sí mismos ciertas maniobras o funcionar en piloto automático en determinadas condiciones, pero todavía necesitan un conductor. Los Tesla alertan al conductor si no detectan que tiene las manos en el volante durante unos 10 segundos, aunque la actriz pornográfica Taylor Jackson se las apañó para grabar un video de 9 minutos en un Tesla.

- No sé dónde le van a permitir legalmente a Tesla poner un millón de robots con ruedas en la calle de la noche a la mañana. Tendrá que ser en un país donde las protestas callejeras se sofoquen con tanques. Porque en cuanto los taxis 100% autónomos empiecen a circular, los taxistas se darán cuenta de que los conductores de Uber no son sus auténticos enemigos y ambos formarán una coalición a la que no tardarán en sumarse camioneros, conductores de autobuses, guardias de tráfico y hasta empresas de recursos de multas. En una ciudad europea no se pueden poner ni patinetes sin remover el cielo y la tierra. Ergo muchísimo menos inundarla de drones que rompen la táctica básica para desincentivar el tráfico en el centro de la ciudad: eliminar la posibilidad de aparcar. Además de que un robotaxi no reemplaza a un solo taxi sino a varios de ellos debido a que no necesita parar para dormir.

- Tesla ya tiene una larguísima lista de espera. Para producir un millón de taxis Tesla anunció la construcción de otra Gigafactory cerca de Berlín, lo cual es cómo Aníbal Barca de campaña por la Península Itálica intentando conquistar Roma con elefantes. Porque Elon, al parecer, no se ha enterado de las razones por las que los coches europeos se fabrican mayormente en Polonia y en España.

- Tesla no es la única intentando producir taxis 100% autónomos. GM, siguiendo los pasos de Waymo, ha presentado su propio prototipo Origin sin volante ni pedales, diseñado por su subsidiaria Cruise con participación de Honda.

Actualización 17/02/2020: Un mes y medio después de escribir el artículo original, las acciones de Tesla cotizan por encima de los 800$. Eso situa la valoración bursátil de Tesla por encima del valor combinado de GM, Ford y Volkswagen. E implica que para ser una valoración mínimamente justificable, Tesla tendría que multiplicar por diez sus ventas en cinco años.

Actualización 02/08/2020: El precio de la acción llega a 1.425$.

Apéndice. Breve historia de coche eléctrico.

La historia del coche eléctico es interesante. Según Wikipedia, hay modelos experimentales que se remontan a 1828. En 1881, Gustave Trouvé presentó un coche eléctrico en la Exposition Internationale d’Électricité de Paris. En 1897, antes de que apareciese el Modelo T de Ford, había taxis eléctricos en Londres. Luego hubo varios factores que hicieron ganar terreno al motor de combustión: facilidad y velocidad de reabastecimiento, mejora de las carreteras para viajar largas distancias y menor coste unitario de producción. Mercedes presentó su primera furgoneta eléctrica en 1975. Volkswage su primer Golf eléctrico en 1976. Incluso General Motors tuvo a la venta su coche eléctrico EV1 entre 1996 y 1999.

Todos hemos visto dramatizaciones cinematográficas sobre pandemias pero ¿Cómo de probable es que sucedan en la realidad? ¿Que probabilidad hay de que el coronavirus de Wuhan (2019-nCoV) se propague por todo el planeta?

Todos hemos visto dramatizaciones cinematográficas sobre pandemias pero ¿Cómo de probable es que sucedan en la realidad? ¿Que probabilidad hay de que el coronavirus de Wuhan (2019-nCoV) se propague por todo el planeta?

A quienes les guste el juego y las apuestas, tienen tres buenas opciones hoy en día: los casinos, Bitcoin y las acciones de Tesla. Se han escrito ríos de tinta sobre Tesla, con acérrimos detractores y fanáticos defensores. Pero hay sorprendentemente pocos artículos que profundicen en el caso, que es lo que yo voy a intentar hacer a continuación.

A quienes les guste el juego y las apuestas, tienen tres buenas opciones hoy en día: los casinos, Bitcoin y las acciones de Tesla. Se han escrito ríos de tinta sobre Tesla, con acérrimos detractores y fanáticos defensores. Pero hay sorprendentemente pocos artículos que profundicen en el caso, que es lo que yo voy a intentar hacer a continuación. Pero es que precio de las acciones de Tesla subió incluso cuando en 2015 la empresa publicó un April’s Fool note (el equivalente anglosajón al Día de los Santos Inocentes) anunciando que sacarían al mercado un

Pero es que precio de las acciones de Tesla subió incluso cuando en 2015 la empresa publicó un April’s Fool note (el equivalente anglosajón al Día de los Santos Inocentes) anunciando que sacarían al mercado un  Una diferencia importante de los coches que se conducen por si mismos es que el interior no tiene por qué parecerse en absoluto al de un coche clásico. Para empezar, en un coche 100% autónomo ni siquiera sería necesario que hubiese un conductor mirando constantemente hacia la carretera. En cambio, los pasajeros podrían ir sentados alrededor de una mesa central.

Una diferencia importante de los coches que se conducen por si mismos es que el interior no tiene por qué parecerse en absoluto al de un coche clásico. Para empezar, en un coche 100% autónomo ni siquiera sería necesario que hubiese un conductor mirando constantemente hacia la carretera. En cambio, los pasajeros podrían ir sentados alrededor de una mesa central. Tesla ha dado pasos importantes en la modificación del interfaz de usuario, posiblemente llevándolo demasiado lejos demasiado pronto. El Modelo 3 tiene una pantalla de 15″ y el Modelo X una de 17″. Tesla ha intentado centralizarlo todo en un dashboard de control. Esto tiene dos grandes inconvenientes: 1) es imposible hacer nada en el dashboard sin quitar la vista de la carretera lo cual puede suponer un grave peligro, y 2) la pantalla es un punto único de fallo, si se rompe o deja de funcionar adecuadamente por un problema software, eso es casi lo mismo que todo el coche quede inoperante.

Tesla ha dado pasos importantes en la modificación del interfaz de usuario, posiblemente llevándolo demasiado lejos demasiado pronto. El Modelo 3 tiene una pantalla de 15″ y el Modelo X una de 17″. Tesla ha intentado centralizarlo todo en un dashboard de control. Esto tiene dos grandes inconvenientes: 1) es imposible hacer nada en el dashboard sin quitar la vista de la carretera lo cual puede suponer un grave peligro, y 2) la pantalla es un punto único de fallo, si se rompe o deja de funcionar adecuadamente por un problema software, eso es casi lo mismo que todo el coche quede inoperante. El anuncio de Elon Musk de poner un millón de taxis autónomos en circulación hacia finales de 2020 para que sus propietarios ganen dinero cómo los conductores de Uber pero sin conducir, me parece infactible por cuatro motivos:

El anuncio de Elon Musk de poner un millón de taxis autónomos en circulación hacia finales de 2020 para que sus propietarios ganen dinero cómo los conductores de Uber pero sin conducir, me parece infactible por cuatro motivos: Ya escribí en 2012

Ya escribí en 2012  En este artículo expongo algunos consejos sobre cómo hacer el triaje de funcionalidades que podría contener un producto.

En este artículo expongo algunos consejos sobre cómo hacer el triaje de funcionalidades que podría contener un producto.